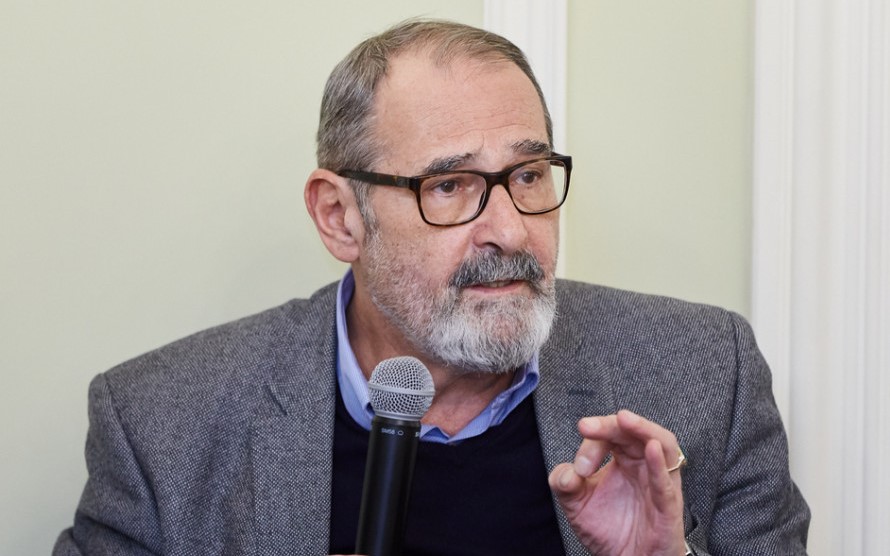

В 2024 году отмечается 90-летие американского психолога, профессора Калифорнийского университета в Сан-Франциско, специалиста в области психологии эмоций и межличностного общения Пола Экмана. Этому событию авторы — Алексей Николаевич Гусев, Михаил Степанович Баев, Александр Евгеньевич Кремлёв — посвятили статью «Автоматическая оценка лицевых экспрессий в психологии: проблемы, подходы, практическая реализация».

Развитие технологий распознавания эмоций

Точная и надежная оценка эмоциональных экспрессий по лицу человека интересует академических ученых и практиков более 150 лет (Duchenne, 1990; Дарвин, Экман, 2014). В основе исследований психологов и представителей смежных наук, как правило, лежала одна из концепций базовых эмоций. В этом контексте кратко остановимся на проблеме базовых эмоций.

В опубликованной в 1872 году книге «О выражении эмоций у человека и животных» Чарльз Дарвин сравнил внешние проявления эмоций у различных видов животных и человека, поместив его в один эволюционный ряд с животными (Дарвин, Экман, 2014). Там же он впервые высказал предположение о наличии типичных выражений лица, соответствующих определенным эмоциям. Эта гипотеза оказала влияние на все дальнейшие исследования в области мимических проявлений эмоций.

Безусловно, теоретические представления П. Экмана о базовых эмоциях являются развитием идей Ч. Дарвина. Подчеркнем, что серьезным теоретически вкладом П. Экмана в науку об эмоциях является разработанная им концепция базовых эмоций. Он выделяет следующие: удивление, печаль, страх, злость, отвращение, презрение, радость. Экман особо подчеркивает адаптивную ценность базовых эмоций как универсальных автоматических оценочных инструментов для решения важнейших и типичных задач жизнедеятельности. В случае столкновения с жизненными трудностями эмоции заставляют нас незамедлительно действовать в тех направлениях, которые выбраны эволюцией нашего вида как наилучшие по сравнению с другими для достижения типичной цели в типичных обстоятельствах (Ekman, 1994).

Представления о необходимости выделения базовых эмоций также разделяют и другие известные ученые. Так, Р. Плутчик выделяет восемь базовых эмоций, включая в них также принятие (доверие) и ожидание (предвкушение) и исключая презрение. В теории К. Изарда описываются 10 фундаментальных, или базовых, эмоций (радость, печаль, гнев, отвращение, презрение, страх, стыд / смущение, вина, удивление, интерес), которые образуют основу мотивационной системы человека. Каждая из этих эмоций уникальна по структуре, мотивационной направленности и субъективным переживаниям.

В определенной степени теоретические взгляды американского ученого в области нейронаук Яака Панксеппа близки взглядам Р. Плутчика и К. Изарда, поскольку он также рассматривает эмоции в эволюционном контексте (Panksepp,1998). Я. Панксепп выделяет инстинктивные эмоции как основные и первичные. В книге Я. Паксеппа и Л. Бивена (Panksepp, Biven, 2012) с характерным названием «Археология сознания» описана таксономия первичных аффективных реакций, включающих семь эмоциональных систем, гомологичных для всех видов млекопитающих, нейрофизиологические механизмы которых основаны на работе подкорковых структур мозга. Они включают в себя: поиск, ярость, страх, похоть (вожделение), заботу, панику / печаль и игровые эмоциональные системы.

Таким образом, так же, как и П. Экман, многие ученые указывают, что выделение базовых эмоций как научных конструктов, а также поиск их проявлений в поведении человека вполне оправданы, по крайней мере, по трем причинам: 1) есть существенные признаки, выделяющие их из остальных эмоций, 2) они имеют особую адаптивную ценность при решении фундаментальных жизненных задач, 3) они могут рассматриваться как базовые элементы, из которых состоят более сложные, составные эмоции (Ekman, 1992).

Многие современные авторы также разделяют мнение о возможности и необходимости выделять базовые эмоции и на их основе изучать более сложный и широкий круг различных сочетаний базовых эмоций — так называемых составных эмоций (Du, Tao, Martinez, 2014).

Как ни странно, именно из-за теории базовых эмоций распознавание выражений лица долгое время рассматривалось, а во многих случаях и сейчас рассматривается как самая простая задача в оценке аффективного состояния человека. В настоящее время ситуация осложняется невысокой психологической грамотностью ИТ-специалистов, которые работают по следующей схеме: нужно обучить нейросеть определять выражения лица человека и оценивать выраженность базовых эмоций в процентах. Далеко не все ученые, работающие в области искусственного интеллекта, понимают, что лицевые экспрессии лица — это не более чем внешнее выражение эмоций (интерфейс) наших переживаний вовне (и не всегда истинное их выражение), а самое главное связано с внутренними чувствами человека, тем, что и как он переживает (из устного выступления нейрофизиолога А. Дамасио в 2021 г.).

Кратко остановимся на основных этапах развития технологий автоматического оценивания лицевых экспрессий как поведенческих показателей эмоций.

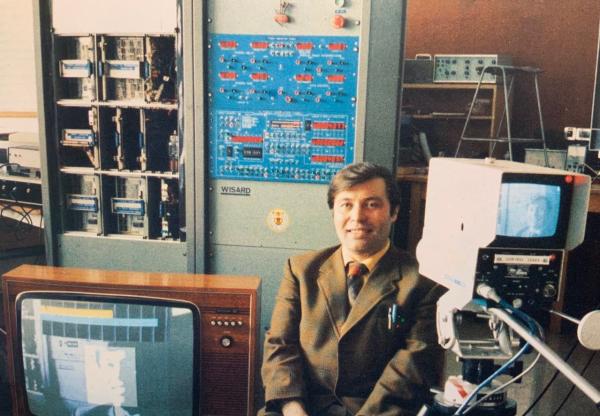

Первой из известных компьютерных систем детекции эмоций на видеозаписи была система WISARD (аббревиатура от: Wilkie, Igor and Stonham's Recognition Device), разработанная группой И. Александера в 1981 году (Aleksander, 1983; Stonham, 1985). Это была одна из первых коммерческих систем компьютерного зрения. В этом проекте была решена задача автоматического различения нейтрального и улыбающегося лица с помощью нейросетевого алгоритма, реализованного в Брунельском университете с использованием компьютера, специального оборудования и аналоговой видеокамеры (рис. 1). Для конца 70-х — начала 80-х годов XX века это было весьма значительным достижением в области affective computing.

Розалин Пикар ввела термин affective computing — научное направление, связанное с компьютерными технологиями по распознаванию и моделированию эмоциональных экспрессий человека. Она подчеркивала, что для эффективного взаимодействия в системе «человек — компьютер» необходимо разрабатывать технологии распознавания и выражения эмоций (Picard, 1995, 1997). В этом контексте нельзя не упомянуть принципиальный вклад в данную область прикладной науки Алекса Пентланда — основателя и первого руководителя MIT Media Lab. Он создал первые компьютерные алгоритмы обнаружения и анализа лицевых экспрессий в оптическом потоке в реальном времени (Mase, Pentland, 1989; Essa, Darrell, Pentland, 1994). Тем не менее, анализ публикаций лаборатории MIT Media Lab показал, что апробированный исследователями подход к анализу изменения лицевых экспрессий не получил своего развития.

В последние два десятилетия появились коммерческие варианты компьютерных систем для автоматизированного анализа выражения эмоций, такие как FaceReader (Noldus Information Technology, Нидерланды), EmoDetect (Нейроботикс, Россия), аналогичные разработки известных IT-компаний США — Microsoft, Amazon. Однако, отметим, что компания Microsoft закрыла доступ пользователей к анализу эмоциональных экспрессий с помощью своей системы Azure в связи с невысокой надежностью этого инструмента, а компания Amazon не рекомендует использовать сервисы системы Amazon Rekognition для серьезных исследований.

В последние годы серьезные разработки в этой области представлены шведской компанией Smart Eye Group, включающей такие известные IT-компании, как Affectiva и iMotions. Подобные системы востребованы для оценки персонала, контроля бдительности, нейромаркетинга, судебно-психологической экспертизы, проведения научных исследований в области affective science.

В современной литературе по affective computing можно выделить два подхода (селективный и комплексный) к автоматическому анализу лицевых экспрессий, в которых по-разному решается эта проблема (Rosenberg, Ekman, 2020). В целом задача, стоящая перед исследователями, может быть сформулирована следующим образом: компьютерная система должна с приемлемой точностью и надежностью обнаруживать разные проявления мимической активности (МА), например, отдельные двигательные единицы FACS (Facial Action Coding System), базовые эмоции и другие паттерны лицевых экспрессий. Система FACS разработана П. Экманом и его коллегами для описания всех возможных движений лицевой поверхности в виде отдельных двигательных единиц (action units, AUs) (Ekman, Friesen, Hager, 2002). Подчеркнем, что FACS AUs являются общепринятыми единицами описания МА.

В наших публикациях (Gusev, Baev, Kremlev, 2021; Гусев, Баев, Кремлев, 2021) показано, что так называемый селективный подход (selective approach) основан на поиске соответствия определенных выражений лица образцам из ограниченного набора базовых эмоций или AUs. Такого рода наборы составляют обучающую выборку фотографий или видеозаписей, аннотированных квалифицированными экспертами. Другим вариантом составления выборки является краудсорсинг, где в качестве «экспертов» используются обычные люди. Характерные особенности и проблемы этого подхода состоят в следующем.

1. Используются нейросети, обученные на ограниченной и, как правило, маловариативной выборке фотографий (редко — видеозаписей) лиц людей с выражением шести-семи базовых эмоций и отдельных AUs. Проблема состоит в том, для обучения нейросети нужны обучающие выборки, аннотированные опытными экспертами, а получить их крайне сложно. Тем более, создать такие выборки, где были бы в большом количестве представлены разные AUs, микровыражения лица (быстрые движения лица, длительностью менее 500 мс), не говоря уже о том, что эти данные нужно собрать на людях разного пола, возраста, национальностей, этнических групп.

На наш взгляд, серьезным недостатком этого подхода является то, что эксперты, аннотирующие фотографии, составляющие обучающую выборку, оценивают каждое фото на предмет выраженности в нем эмоции или какой-либо AU статически, по впечатлению, а не анализируют видеозапись, оценивая мимические проявления в динамике. По нашему мнению, это серьезная ошибка, поскольку AUs — это двигательные феномены. О последнем весьма недвусмысленно писал П. Экман (Rosenberg, Ekman, 2020). Нам пока не известны разработки, в которых нейросети обучались на видеозаписях, оцененных экспертами. По крайней мере, широко распространенные варианты программного обеспечения компаний Noldus Information Technology или Affectiva разрабатывались с использование большой базы аннотированных фотографий или отдельных фреймов видеозаписей с ограниченным набором интенсивно выраженных эмоций и отдельных AUs.

В реальности ситуация детекции базовых эмоций осложняется тем, что фактически дискретная теория эмоций, лежащая в основе нейросетевого классификатора, переворачивается с ног на голову — мы ждем выделения на видеозаписи лица выражения конкретной эмоции, а получаем набор весовых коэффициентов в процентах, что является взаимопротиворечивым результатом. Противоречие заключается в том, базовые эмоции в обучающей выборке категоризовались экспертами как характерные композиции AUs, а обученная на этой основе нейросеть «не знает» об этом, вынося решение, исходя из своего общего «впечатления» схожести отдельного кадра видеозаписи с определенным набором фото- или видеоизображений, аннотированных экспертами.

Второе противоречие системы, основанной на обучающей выборке базовых эмоций, — это отступление (вторичное) от принципов анализа выражений лица. Как результат, мы получаем слишком узкий спектр описаний лицевых экспрессий — только эмоции. В парадигме П. Экмана выражения лица анализируются как совокупность движений, автор однозначно указывал на то, что видимые экспертом движения могут иметь не только эмоциональную коннотацию. Они могут быть связаны с приданием им определенных смыслов, могут служить речью — так называемыми conversational signals, могут проявляться как индивидуальные мимические привычки. Отдельно подчеркнем, что движения лица могут образовывать весьма сложные паттерны, в том числе паттерны не только пространственные, но и временные.

2. В силу особенностей используемых компьютерных алгоритмов и ограниченности обучающих выборок быстрые движения (микровыражения) лица не определяются или определяются очень плохо.

3. В рамках данного подхода у 7–10% популяции людей в силу их индивидуальных особенностей и/или неврологических проблем невозможно оценить эмоции по выражению лица. Описать мимическую активность таких людей тоже сложно, поскольку нейросетевые алгоритмы выделяют AUs с невысокой надежностью. Данное обстоятельство является критичным при использовании селективных систем в ходе полностью автоматического анализа мимики человека, например при анализе дистанционного интервью. Таким образом, необходима предварительная экспертная оценка МА человека на предмет возможности применения подобной систем. Последнее нам кажется проблематичным при полностью автоматическом анализе видеозаписей, например, в случае массового проведения дистанционных видеоинтервью.

4. Необходим учет расовой и этнической принадлежности лица анализируемого человека, что, в свою очередь, требует использования для обучения нейросети соответствующих выборок. В настоящее время обучающие выборки созданы для очень ограниченного числа рас (см., например, возможности ПО Face Reader, где предлагается выбор нейросетевой модели для анализа представителей двух расовых групп.

5. При использовании системы необходима ее предварительная ручная калибровка по нейтральному выражения лица анализируемого респондента для исключения влияния анатомических особенностей его лица на мимическое выражение определенных эмоций.

6. В связи с тем, что наличие эмоций и их сочетаний на лице в связи с особенностями этого подхода представляет собой вероятностную величину, приходится использовать разные настройки чувствительности компьютерной системы. Например, компания Affectiva при настройке своего ПО предлагает пользователям в зависимости от решаемой задачи выбор из трех уровней срабатывания алгоритма обнаружения эмоций.

7. Проблематичность описания и категоризации МА детей до 5–7 лет в дискурсе выражений эмоций. Как указывает известный исследователь эмоциональных экспрессий у детей Х. Остер, в современной психологии детская мимика описывается только при помощи FACS и BabyFACS, т.е. как последовательность выразительных движений лица (Oster, 2005).

Комплексный подход (comprehensive approach) к анализу МА, в рамках которого мы работаем, базируется на выделении и анализе сочетаний AUs во времени. Его особенности и преимущества следующие.

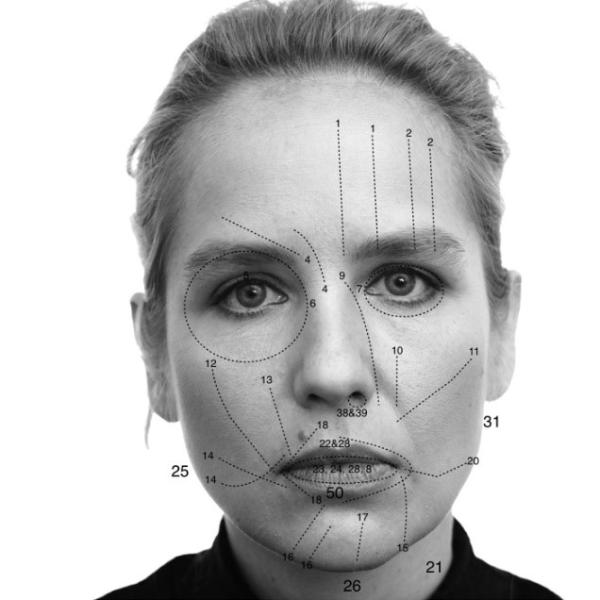

1. Непосредственное выделение на видеозаписи отдельных FACS AUs как основных единиц анализа МА позволяет описывать все возможные выражения лица. В настоящее время система FACS получила самое широкое распространение в мире как способ универсального описания движений, наблюдаемых на поверхности лица. Еще раз отметим, что единицей анализа в системе FACS является AU как характерное изменение поверхности лица в форме отдельного движения (например, губ, бровей, век, носогубных складок). Согласно руководству по FACS, в ходе визуального анализа лица человека выделяют набор AUs (рис. 2).

Особо отметим, что система FACS не задает теоретико-методологические рамки для оценки (категоризации) мимических выражений эмоций, тем более выделения определенного набора базовых эмоций (Ekman, Friesen, Hager, 2002). В современной литературе есть известная дискуссия о том, какие эмоции отражаются в МА, какие из них базовые и сколько их (см., например: Rosenberg, Ekman, 2020; Davidson, Scherer, Goldsmith, 2003; Davis, Panksepp, 2018; Barrett et al., 2019; Барретт, 2018). Поэтому мы акцентируем внимание на том, что FACS — это система инвариантного описания МА, т.е. инструмент, который можно использовать для выделения на лице выражения эмоций и других сложных паттернов МА вне зависимости от того, как разные авторы понимают и операционализируют задачу обнаружения эмоций на лице человека.

Система FACS не связана с какими-либо теоретическими предположениями о природе эмоциональных экспрессий, она основана на очевидной и эмпирически подтвержденной связи активности отдельных лицевых мышц и мышечных с групп с соответствующими изменениями поверхности лица. На наш взгляд, это важно, поскольку даже профессиональные психологи нередко смешивают эти две проблемы — описание МА и ее категоризацию в виде эмоциональных экспрессий. FACS — это не более чем инструмент для базовой оценки МА, способ систематической фиксации в поле восприятия и кодирования определенных движений поверхности лица. Например, AU2 — это поднятие внешней части брови, AU41 — опускание надпереносья, a AU20 — растяжение губ (см. номера отдельных AUs на рис. 1). За выделением AUs всегда лежит напряжение или расслабление лицевых мышц. Например, за AU2 стоит сокращение латеральной части лобной мышцы, за AU41 — сокращение мышцы гордецов, а за AU20 — сокращение так называемой мышцы смеха.

2. Возможность оценивать быстрые движения лица (микровыражения), в том числе асимметричные.

3. Возможность оценки индивидуальных экспрессивных особенностей МА, например, обнаружение мимических гиперкинезов, индивидуальных мимических привычек (мимических маньеризмов), сложных паттернов мимики. Еще раз подчеркнем, что эти мимические феномены оцениваются как появление соответствующих движений на поверхности лица, т.е. как отдельные AUs или их комбинация, а не как итоговое «впечатление» нейросетевого классификатора.

4. Независимость от расовой принадлежности человека, поскольку данный подход не ограничен особенностями обучающей выборки фото /видеоизображений лиц.

5. Не требуется индивидуальная настройка компьютерной системы в соответствии с особенностями анализируемой выборки и решаемой задачи, поскольку в ходе анализа конкретной видеозаписи оцениваются текущие изменения МА конкретного человека.

6. Нет возрастных ограничений по оценке базовых проявлений МА, поскольку описывается появление AUs, а не эмоции.

Ниже рассмотрим важные аспекты методологии и технологии, положенные в основу создания ПО для автоматической оценки лицевых экспрессий.

Разработка технологии оценки МА

При создании конкретных алгоритмов автоматизированного анализа МА мы использовали два важных методических принципа.

- прямая оценка изменений света на поверхности лица как характерных признаков для обнаружения AUs и принципиальный отказ от использования нейросетей как метода косвенного оценивания AUs;

- моделирование восприятия экспертом особенностей перемещений поверхности лица при обнаружении отдельных AUs с учетом топографии движений лицевой поверхности, характерной для реального движения, асимметрии, распределения его пространственного внимания в ходе визуального наблюдения за движениями лица другого человека, характера процесса принятия решения о наличии / отсутствии AUs в соответствии с рекомендациями FACS (рис. 2).

При разработке ПО нами были созданы авторские процедуры компьютерного зрения (CV), специфически ориентированные на анализ движений поверхности лица в отдельных его частях и характерные особенности проявления разных AUs. Необходимость создания новых процедур CV была вызвана тем, что стандартные процедуры OpenCV представляют собой универсальные способы преобразования изменений светового потока в паттерны движения и не ориентированы на анализ характерных сдвигов поверхности лица. Мы исходили из того, каким образом изменения света, попадающие в зрительную систему наблюдателя, преобразуются в двигательные перцептивные инварианты (Гибсон, 1988). Фактически разработанные нами процедуры CV представляют собой инструменты поиска максимального соответствия механизмов зрительного восприятия современным способам анализа изменений светового потока, зарегистрированного видеокамерой.

Всего в процессе анализа распределения света на лицевой поверхности используется более 400 измерительных элементов, перекрывающих друг друга. Таким образом, были созданы компьютерные процедуры, позволяющие анализировать изменение поверхности лица в тех направлениях, которые соответствуют каждой из AUs. Например, очевидно, что метрика для обнаружения движений внутренних частей бровей вверх и друг к другу (AUs 1+4) — это совсем другая метрика по сравнению с горизонтальным сжатием нижних век (AU 7).

Описывая в целом разработанный нами алгоритм анализа МА, укажем, что фактически при выделении отдельных AUs нами был реализован принцип многослойного анализа МА:

- обнаружение лица человека в видеопотоке, выделение артефактов, оценка качества видеозаписи;

- анализ изменений распределения света от кадра к кадру в разных участках поверхности лица, выделение значимых изменений, таких как смещение кожи, образование складок, углубление морщин;

- сопоставление выделенных изменений друг с другом в соответствии с анатомическим строением лица и схемой FACS;

- выделение отдельных AUs, их начала и окончания;

- расчет интегральных показателей МА, например: частота AUs в единицу времени, асимметрия, сочетание AUs и речи;

- сложная категоризация паттернов МА как характерных проявлений мимического поведения: истинные эмоции, эмблемы эмоций, придание эмоциональной модальности речевому высказыванию, индивидуальные мимические привычки, выделение значимых фрагментов речи и др.;

- визуализация результатов анализа на временной оси и построение таблицы результатов анализа МА.

В ходе нашей работы была создана система правил, на основании которых «сырые» данные об изменении света преобразуются в движение поверхностей, а они, в свою очередь, — в AUs. Фактически эти правила и их соотношения могут быть прообразом нового компьютерного языка для анализа МА.

Возможности разработанной технологии анализа МА

Для проведения автоматического анализа лицевых экспрессий необходимы видеозаписи разрешением не хуже HD, на которых лицо человека записано анфас (с поворотами головы влево-вправо, вверх-вниз не более, чем на 20 градусов) и занимает по высоте не менее 350–400 px. Обработка видеозаписей выполняется как в среде Windows (на локальном компьютере), так и в среде Ubuntu Linux (на удаленном сервере, загрузка видео и визуализация данных с помощью тонкого клиента).

Всего с высокой точностью обнаруживаются 27 основных AUs FACS, а также семь базовых эмоций (радость, удивление, презрение, печаль, отвращение, страх, гнев) и 15 паттернов эмоциональных экспрессий, характеризующих разные эмоциональные состояния (страх / стресс, совладание со стрессом, напряжение, контроль улыбки и др.) (Гусев, Баев, Лебедева, Савинкина, 2024).

Для эмпирической верификации точности и надежности работы ПО мы использовали две базы данных микро- и макровыражений лица — CASME II (Yan et al., 2014) и SAMM (Yap, Kendrick, Yap, 2020).

Разработанное ПО позволяет интегрировать на одной временной оси результаты транскрибации речи, данные анализа голоса респондента, при необходимости результаты полиграфологического исследования.

Еще раз подчеркнем, что методология, используемая в разработанной нами компьютерной системе, не зависит от теоретической базы, которой пользуется исследователь. Например, можно проводить анализ лицевой активности в дискурсе базовых эмоций, с использованием специфических паттернов лицевых экспрессий или просто использовать статистику двигательных единиц (как было сделано нами в крупном проекте, где мы смогли разделить видеозаписи кадровых интервью по уровню реакции респондентов на стрессовые вопросы на основе статистического анализа нескольких двигательных единиц).

Результаты анализа лицевых экспрессий, полученные в рамках научных проектов, выполненных авторами

Разработанное ПО использовалось нами при создании методики автоматизированного анализа кадровых интервью совместно с HR-службой одной из крупных промышленных компаний РФ на выборке более 4.000 кадровых видеоинтервью (Гусев, Баев, Мачужак, Подрезова, 2023). В исследовании приняли участие руководители и специалисты различных подразделений, которым HR-службой было предложено дистанционно ответить на ряд вопросов стандартизированного видеоинтервью. Целью интервью была поддержка принятия кадровых решений о назначение на вышестоящие должности.

По согласованию со специалистами по управлению персоналом проведенный анализ видеоинтервью был направлен на оценку:

- проявлений признаков совладания со стрессом, наличие / отсутствие признаков напряжения;

- выраженности у респондентов активного внимания, включённости, интереса;

- негативной установки в общении;

- переживаний опасности, тревоги, неудовольствия, фрустрированности.

С использованием указанных выше критериев все проанализированные видеозаписи были оценены по степени соответствия сотрудника ожиданиям руководства предприятий при рекомендации его на повышение в должности: «соответствует ожиданиям», «соответствует частично», «не соответствует».

1. В группу «соответствующие» вошли видеозаписи, в которых были зафиксированы минимальные уровни совладания со стрессом, отсутствие негативной установки в общении, минимальные уровни переживания опасности и недовольства, а также максимальные уровни активного внимания и спокойствия. В этой группе оказалось 1843 видеозаписи, или 45,6%.

2. В группу «соответствует частично» вошли видеозаписи со средним или низким уровнями совладания со стрессом, наличием негативной установки в общении, переживания опасности и недовольства. В данной группе оказалось 1956 видеозаписей, или 48,4%.

3. В группу «не соответствующие» вошли видеозаписи, где были зафиксированы экстремальные или высокие уровни проявления стресса, а также одновременно были обнаружены признаки негативной установки в общении, неудовольствия. В данной группе оказалось 239 видеозаписей, или 6%.

Для верификации эффективности использованных нами алгоритмов автоматизированной оценки видеоинтервью мы сопоставили полученные данные с оценками опытных специалистов по управлению персоналом. Для экспертизы из каждой группы были случайным образом выбраны по 20 видеозаписей, соответствующих разным респондентам. Результаты регрессионного анализа (процедура «Логистическая регрессия») показали хорошую возможность прогнозирования результатов классификации видеозаписей на основе анализа лицевых экспрессий по оценкам экспертов: были получены достаточно высокие значения коэффициента множественной регрессии R2, а также высокий процент правильных предсказаний.

Мы полагаем, что реализованный нами метод оценки эмоционального состояния сотрудника, отвечающего на вопросы кадрового интервью, позволяет оценивать изменение его эмоционального состояния, за которым стоит смысловое отношение к работе, карьере, решению производственных задач. Отметим, что содержание интервью было разработано специалистами по управлению персоналом в соответствии с используемыми в компании критериями оценки сотрудника как перспективного руководителя.

Наше ПО также использовалось в ходе экспериментального исследования поведения человека в особых условиях профессиональной деятельности в рамках проекта «Иммерсия» Института медико-биологических проблем РАН (Гусев, Баев, Лебедева, Савинкина, 2024). Целью нашего исследования была эмпирическая апробация новой методологии и технологии оценивания изменения лицевых экспрессий на видеозаписи, отражающих изменение эмоционального состояния испытателей в условиях 7-суточного эксперимента, в котором моделировались условия гипогравитации методом «сухой» иммерсии. Дважды в день, утром и вечером, проводилось видеоинтервью (DPC — daily planning conference). В ходе анализа данных проводилось детальное описание изменений лицевых экспрессий в ходе эксперимента, отражающих закономерные изменения эмоционального состояния участников исследования, сопоставляемые с характерными для условий этого эксперимента переживаниями.

В соответствии с принципами, описанными в FACS Investigator`s Guide (Ekman, Friesen and Hager, 2002), выделялись семь базовых эмоций: радость (Happiness), печаль (Sadness), страх (Fear), злость (Anger), презрение (Contempt), удивление (Surprise) и отвращение (Disgust). Кроме эмоции радости в МА выделялись два внешне похожих на нее паттерна МА, которые, на наш взгляд, в полной мере не могут рассматриваться как мимическое выражение базовой эмоции радость: «социальная улыбка» (Social Smile) и «игривая улыбка» (Coy Smile).

Нами также был сконструирован паттерн Negative Attitude, характеризующий общую негативную позицию человека в ситуации общения и предназначенный для оценки внешнего выражения лица, соответствующего эмоциональному переживанию отрицательного характера. Этот паттерн выделен для обозначения МА, включающей появление одной из четырех отрицательных эмоций: презрение, отвращение, печаль и страх и/или их сочетания выше определенного порога. Еще один показатель негативного выражения лица — паттерн страх / стресс (Pattern fear / stress) — характеризовал общее негативное переживание эмоции страха. Этот паттерн является еще одним вариантом ее оценки. Набор AUs, входящих в паттерн, соответствует внешнему выражению эмоции страха, но отличается от него степенью вклада отдельных AUs и нестрогим сочетанием их появления во времени в отличие от более строгих критериев определения базовых эмоций (Ekman, Friesen, Hager, 2002).

Для выделения состояния эмоционального напряжения был сконструирован паттерн напряжение 2 (Tension 2), соответствующий двухстороннему появлению AU14 выше определенного порога по длительности. Двухстороннее втягивание углов губ традиционно рассматривается как физиологическое проявление стресса (Ellgring, 2008).

Паттерн сужения глаз (Eyes narrowing) выделялся нами как признак повышенной концентрации внимания или отражения физиологической реакции на высыхание склеры. Он проявляется как сужение глазных щелей и оценивается по появлению AU43 средней интенсивности слева или справа.

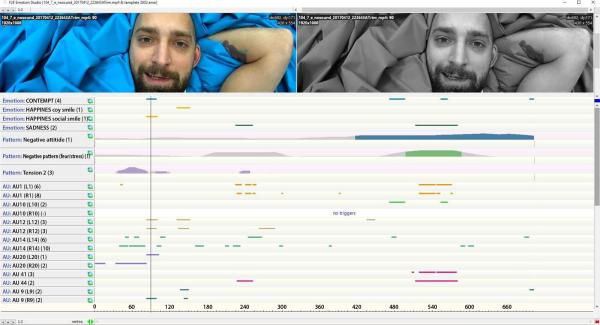

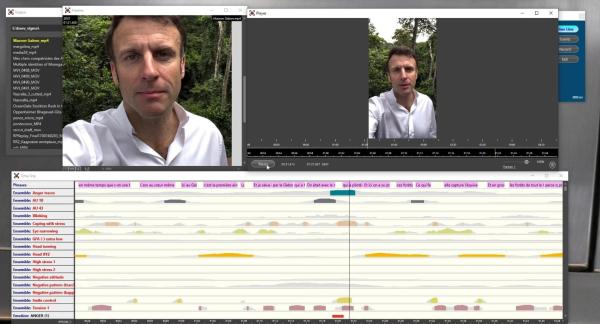

На рис. 3 показаны изменения МА у испытателя 104 вечером в 7 день эксперимента. Во время 23-секундного интервала, выбранного нами для анализа, он сказал следующее: «А какое сегодня число-то? А, 14 октября, 2021 год. Осталось 10 часов до завершения моего участия в этой части эксперимента. Я завтра в 9 часов утра, по идее, должен подняться из этой ванны и не возвращаться в нее в ближайшее время точно. И (глубокий вздох) вот …». На рис. 3 курсором (фрейм 90) отмечен момент практически одновременного появления базовой эмоции презрения (Contempt) и социальной улыбки (Happiness, Social smile). Подчеркнем, что их обнаружение обосновывается композицией симметричной AU12 и асимметричной AU9 (Ekman, Friesen, Hager, 2002). Очевидно, что выражение лица испытателя в этот момент времени выражает именно это сочетание эмоций. Далее (фрейм 240): выделена эмоция печали (Sadness) как сочетание AUs 1 и 44 (там же).

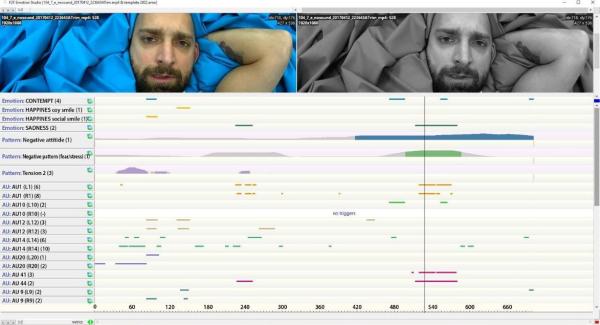

Далее на рис. 4 (фрейм 240): выделена эмоция печали (Sadness) как сочетание AUs 1 и 44 (там же). Там же курсором (фрейм 520) показано более сложное сочетание во времени разных мимических событий: эмоция печали, негативных мимических паттернов Negative Attitude, Fear / Stress. Обращаем внимание на соответствующее этим паттернам появление AUs 1, 10, 14, 41, 44. Также укажем на появление на временной оси паттерна напряжения (Tension 2), определенного нами как сочетание AU14L и AU14R (рис. 3 или 4, фрейм 60).

Результаты показывают, что разработанная нами технология автоматического анализа лицевых экспрессий дает возможность количественно оценить изменение эмоционального состояния участников эксперимента «Сухая иммерсия». Это позволяет дать объективную и не зависящую от самооценок респондентов или опыта эксперта информацию о характерных изменениях МА как надежных поведенческих показателей базовых эмоций и других эмоциональных экспрессий.

Разработанный инструментарий также позволяет оценивать на видеозаписи эмоциональный компонент любых публичных выступлений. На наш взгляд, это важно для оценки не только смыслового содержания выступления, но и характера его воздействия на зрителя. В свою очередь, последнее важно для решения практических задач в областях нейромаркетинга и психологии рекламы. На рис. 5 показаны результаты анализа лицевых экспрессий Эммануэля Макрона.

Обратим внимание читателя на те мимические события, которые расположены в интервале ±1–2 секунды относительно линии курсора.

1. Начиная с точки 1 мин. 17 сек. выделяются характерные ансамбли (паттерны) негативных лицевых экспрессий: паттерны AU10 (связан с приданием негативной модальности высказываниям) и Anger Trace (показатель неудовольствия).

2. Далее в интервале 1 мин. 19–21 сек. появляются характерные мимические знаки, отражающие состояние совладания со стрессом и высоким уровнем напряжения: паттерны Coping with stress, Smile control и Tension 1.

3. Отдельно укажем на появление базовой эмоции гнева (Anger), обозначенное на самой нижней линии таймлайн в виде красной полоски, как весьма редкое мимическое событие.

На наш взгляд результаты такого анализа изменения во времени лицевых экспрессий могут быть весьма полезными психологам и представителям смежных наук для понимания тех смысловых акцентов, которые делаются медийной личностью в ходе публичного выступления вне зависимости от того, насколько ее или его эмоциональные реакции срежиссированы или были достаточно непроизвольными.

Приведем еще один пример из публичного интервью бывшей премьер-министра Новой Зеландии Джасинды Ардерн (рис. 6).

Временные интервалы, соответствующие моментам ее речи, автоматически выделены на таймлайн в виде оранжевых полосок (AU50 speech). Особо подчеркнем, что разработанное нами ПО надежно выделяет различные эмоциональные экспрессии на лице, независимо от того, говорит респондент или молчит. Например, AU20 может категоризоваться и как составная часть эмоции страха, возникающей во время артикуляции, и как средство усиления самой артикуляции для мимического выделения (акцентирования) некоторого важного смыслового фрагмента речи.

Укажем еще на одну важную возможность нашего ПО как средства реализации комплексного подхода в анализе лицевых экспрессий. Оно позволяет выделять различные варианты выражения эмоций. На рис. 6 показано, что на видеозаписи выделяются два варианта улыбок: улыбка, соответствующая базовой эмоции радости — Happiness (рис. 6В), и так называемая социальная улыбка — Social Smile (рис. 6А). Базовая эмоция радости (или так называемая улыбка Дюшенна) определена как комбинация AUs 6 и 12. Тогда как похожая на нее эмоциональная экспрессия «социальная улыбка» категоризуется как билатеральное появление AU12 в форме строго сочетания во времени AU12L и AU12R при отсутствии AU6. Кроме того, анализируя различные сочетания во времени AUs 9, 10, 12, 14, мы можем выделять еще один вариант проявления радости — так называемую «игривую улыбку» (Coy smile).

![Рис. 6. Различные выражения радости. Скриншот экрана ПО, демонстрирующий результаты анализа видеоинтервью Дж. Ардерн (1News. (2023, April 4). Jacinda Ardern: The Final Interview | 1News' John Campbell [Video]). Нижняя линия — номера кадров видеозаписи, 30 fps.](/content/images/%D0%B3%D1%83%D1%81%D0%B5%D0%B26_600x636.jpg)

Укажем на ряд технических ограничений возможностей нашего ПО для автоматического анализа лицевых экспрессий (как, впрочем, и большинства других компьютерных систем): 1) система не относится к категории систем реального времени; 2) анализируемая видеозапись должна быть приемлемого качества: разрешение не хуже, чем full HD (1920×1080), хорошая резкость изображения лица, высота лица в кадре не менее 350–400 px, 3) длительность видеозаписи — не менее 30 сек.; 4) поворот головы человека по вертикали и горизонтали — не более 20 угловых градусов относительно объектива видеокамеры.

В качестве заключения позволим себе обозначить возможные сферы использования технологий автоматического анализа лицевых экспрессий, отвечая на вопрос об их актуальности для психологов:

- возможность перейти от выражения эмоций на лице к пониманию смыслов, от анализа смыслов — к оценке личности и далее — к предсказанию поведения. Это корреспондирует с разработкой процедур искусственного интеллекта, позволяющих анализировать экспрессивное поведение человека;

- нарастающий с каждым годом объем видеоматериалов и высокая трудоемкость оценки МА вручную. Крайний недостаток опытных экспертов;

- использование нового инструментария в академических исследованиях для высокоточного и надежного анализа эмоционального состояния человека;

- востребованность в прикладных исследованиях: клиническая психология, космическая психология, оценка естественности аватаров, обнаружение deepfake;

- практические приложения: оценка персонала, нейромаркетинг, оценка стресса, выгорания, ПТСР.

Литература

- Aleksander, I. (1983). Emergent intelligent properties of progressively structured pattern recognition nets. Pattern Recognition Letters, 1, 375-384. July 1983 North-Holland.

- Barrett, L.F., Adolphs, R., Marsella, S., Martinez, A.M., Pollak, S.D. (2019). Emotional expressions reconsidered: Challenges to inferring emotion from human facial movements. Psychological Science in the Public Interest, 20(1), 1–68. https://doi.org/10.1177/1529100619832930

- Барретт, Л.Ф. (2018). Как рождаются эмоции. Революция в понимании мозга и управлении эмоциями. Манн, Иванов и Фербер.

- Davis, K.L., Panksepp, J. (2018). The emotional foundations of personality: A neurobiological and evolutionary approach. W.W. Norton & Company.

- Дарвин, Ч., Экман, П. (2014). О выражении эмоций у человека и животных. СПб: Питер.

- Davidson, R.J., Scherer, K.R., Goldsmith, H.H. (Eds.) (2003). Handbook of affective sciences. Oxford University Press.

- Duchenne de Boulogne, G.-B. (1990). The mechanism of human facial expression. Cambridge University Press.

- Du, S., Tao, Y., Martinez, A.M. (2014). Compound facial expressions of emotion. PNAS, 111(15), E1454-E1462.

- Ekman, P. (1992). Are there Basic Emotions? Psychological Review, 99(3), 550-553.

- Ekman, P. (1994). All emotions are basic. In P. Ekman & R.J. Davidson (Eds.), The nature of emotions: Fundamental questions (pp. 15-19). Oxford University Press.

- Ekman P., Friesen W.V., Hager J.C. (2002). Facial Action Coding System (FACS): the Manual & the Investigator's Guide. A Human Face, Salt Lake City U.

- Ellgring, H. (2008). Non-verbal communication in Depression. Cambridge: Cambridge Univ. Press.

- Essa, I.A., Darrell, T., Pentland, A. (1994). Tracking Facial Motion. Proceedings of the IEEE Workshop on Nonrigid and Articulate Motion, Austin, Texas.

- Гибсон, Дж. (1988). Экологический подход к зрительному восприятию. М.: Прогресс.

- Гусев, А.Н., Баев, М.С., Кремлев, А.Е. (2021). Метод прямой оценки лицевых экспрессий на видеозаписи: от восприятия эксперта к компьютерному зрению. В Социально-психологические проблемы цифровизации современного общества: личность, организация, управление. Тверь: Тверской государственный университет.

- Гусев, А.Н., Баев, М.С., Лебедева, С.А., Савинкина, А.О. (2024). Изменение эмоционального состояния испытателей по лицевым экспрессиям в условиях 7-суточной сухой иммерсии. Национальный психологический журнал, 19(1), 158-174.

- Гусев, А.Н., Баев, М.С., Мачужак, А.В., Подрезова, А.В. (2023). О возможности автоматизированной оценки видеоинтервью по лицевым экспрессиям. Организационная психология, 13(2), 121-138.

- Gusev, A., Baev, M., Kremlev, A. (2021). The Advantage of the Methodology for Direct Evaluation of Facial Expressions. International Journal of Psychophysiology, 168(Supplement), 151-151. Elsevier BV.

- Mase, K., Pentland, A. (1989). Automatic lipreading by computer. I.E.I.C.E., Proceedings of the Image Understanding Symposium, 65-70.

- Oster, H. (2005). The repertoire of infant facial expressions: an ontogenetic perspective. In J. Nadel & D. Muir (Eds.), Emotional development: Recent research advances (pp. 261–292). Oxford University Press.

- Panksepp, J. (1998). Affective neuroscience: The foundations of human and animal emotions. Oxford University Press.

- Panksepp, J., Biven, L. (2012). The archaeology of mind: Neuroevolutionary origins of human emotions. W.W. Norton & Company.

- Picard, R.W. (1997). Affective Computing. MIT Press.

- Rosenberg, E.L., Ekman, P. (Eds.). (2020). What the face reveals: Basic and applied studies of spontaneous expression using the Facial Action Coding System (FACS). Oxford University Press.

- Stonham, T.J. (1985). Practical face recognition and verification with WISARD. In Proceedings of the NATO Advanced Research Workshop on "Aspects of Face Processing" (pp. 426-441).

- Yan, W., Li, X., Wang, S., Zhao, G., Liu, Y., Chen, Y., Fu, X. (2014). CASME II: An IMPROVED Spontaneous Micro-Expression database and the baseline evaluation. PLoS ONE, 9(1). https://doi.org/10.1371/journal.pone.0086041

- Yap, C.H., Kendrick, C., Yap, M.H. (2020). SAMM long Videos: A spontaneous Facial micro- and Macro-Expressions Dataset. 2020 15th IEEE International Conference on Automatic Face and Gesture Recognition (FG 2020). https://doi.org/10.1109/fg47880

* Instagram — запрещен в РФ, принадлежит компании Meta, признанной экстремистской организацией и запрещенной в России (прим. ред.).

Комментариев пока нет – Вы можете оставить первый

, чтобы комментировать